线性回归

线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,其表达形式为y = w'x+e,e为误差服从均值为0的正态分布。它用于分析变量之间的依赖关系,尤其是变量间相互的变化规律是其重点考察的方面,这种变量间的关系最终通过回归方程来进行描述和反映,使人们能够准确认识一个变量受其他变量影响的程度是多少,进而为预测提供可靠依据。

数据说明:

背景说明:

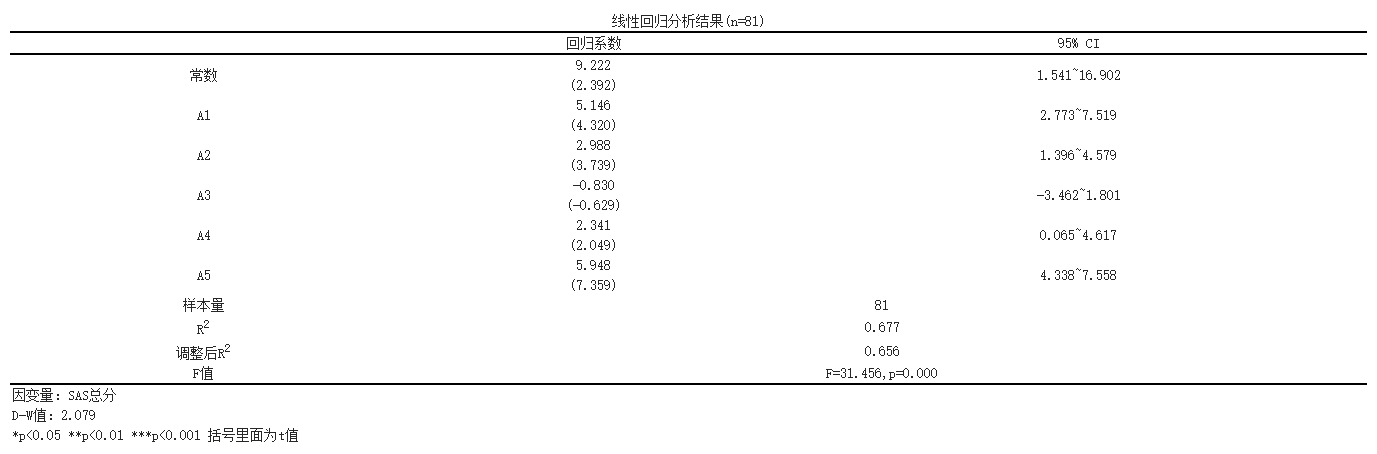

线性回归是一种常用的统计分析方法,用于探究自变量和因变量之间的线性关系。在这个分析中,我们使用了81个观测样本进行了线性回归分析,以研究自变量(A1、A2、A3、A4和A5)对因变量(SAS总分)的影响。在这个分析中,我们使用了81个观测样本进行了线性回归分析,以研究自变量(A1、A2、A3、A4和A5)对因变量(SAS总分)的影响。

分析结果如下所示:

结果显示,将SAS总分作为因变量,['A1', 'A2', 'A3', 'A4', 'A5']作为自变量,建立自变量和因变量的多元回归模型,R2(RSquare) 代表回归模型中自变量对因变量变异的解释程度,是分析回归结果的开始,数据显示;模型R方值为0.6771,意味着['A1', 'A2', 'A3', 'A4', 'A5']可以解释SAS总分的67.71%变化原因,通过F检验来判断回归模型的回归效果,即检验因变量与所有自变量之间的线性关系是否显著,也可以用来检验模型的统计学意义。由结果可得F值为31.456,P值为0.0,模型公式为:SAS总分 = 9.222 + 5.146*A1 + 2.988*A2 - 0.83*A3 + 2.341*A4 + 5.948*A5。

SPSSMAX还提供另一个格式的输出结果:

参考文献:

[1] Cohen, J., Cohen P., West, S.G., & Aiken, L.S. Applied multiple regression/correlation analysis for the behavioral sciences. Hillsdale, NJ: Lawrence Erlbaum Associates. 2003.

[2] Draper, N.R. and Smith, H. Applied Regression Analysis. Wiley Series in Probability and Statistics. 1998.

[3] 孙荣恒.应用数理统计(第三版).北京:科学出版社,2014:204-206

[4] alton, Francis. Regression Towards Mediocrity in Hereditary Stature (PDF). Journal of the Anthropological Institute. 1886, 15: 246–263

关注微信公众号发送【示例数据】获取SPSSMAX练习示例数据。